AutoSAM告知你怎样在医疗行业更快更好开发大模型

发布日期:2023-08-14 作者:康为 点击:

形成预训练Transformer(Generative Pre-trained Transformer,GPT)系列模型的顺利标明,假设在大范围信息上进行训练,大型话语模型在零样件和非可视域中的少许快照任务上的功能与最新技术相当。

受GPT的启迪,Segment Anything(SAM)为图片分割任务引入了1个“根基模型”。他们采集了1100万张图片,并设计了1个半智能信息引擎,平均每张图片形成约100个Mask,进而总共形成10亿个Mask。接着,SAM在该SAM-1B信息集上应用Vision Transformer(ViT)Backbone训练1个大型可prompt模型。在23多个信息集上应用各类零样件任务进行评价后,SAM显现出对大多数自然图片的推广前景。

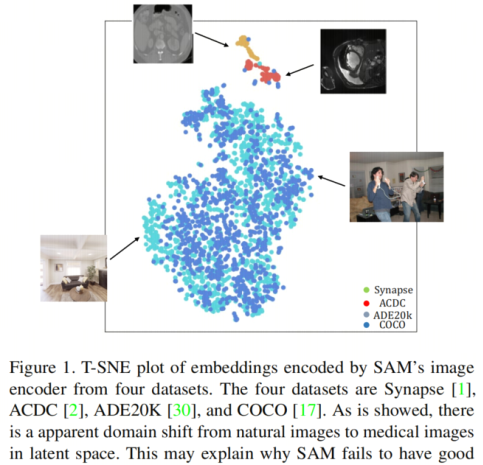

但是,随着SAM在医学图片行业引发人们的存眷,可以观测到SAM在零样件设置下不可较好地推广到医学图片。将用自然图片训练的模型转换为医学图片的挑衅可归因于2个首要原因:

外表上的较大差别:自然图片和医学图片在色彩、亮度和对照度方面体现出明显差别。因为所应用的成像形式,比如CT扫描、MRI或超声波,医学图片往往拥有不同的特点;

目的物体的模糊边缘:医学图片时常显现不同组织和器官之间的模糊边缘。受过训练的医学顾问对解剖构造有必须的了解,而且可能辨认出针对仅依据自然图片训练的模型来说能够不显著的细微边缘。

参考到采集与SAM-1B大小相当的医学分割信息集的艰难,开拓预训练的SAM中能否有可用来医学图片分割的常识是至关主要的。

另外,基于prompt的分割能够不太合适真正世界的运用情景,原因如下:

为多类供应prompt很耗时。针对大多数公共医学图片分割的挑衅,它总是须要同时分割多个类型。为每个类型输入确切的prompt能够会变得麻烦,特别是当器官和组织很小而且相互相邻时;

分割功能在较大程度上取决于prompt品质。制造准确的prompt须要特定行业的顾问常识,而这并不应用于一切状况。

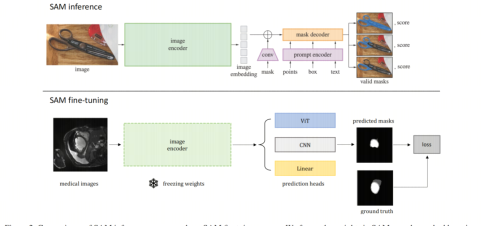

参考到这类限定,本文提出了一类在医学图片信息集上微调SAM的直接方式,即解冻SAM编码器的权重,并在其上增加预判Head进行训练。解冻权重的原因是SAM是1个大模型,而且大多数权重由编码器奉献。依据试验结果,因为硬件需要高,对编码器妥协码器进行微调不单对一切开发职员来说不太容易,况且还会造成较差的分割功能。

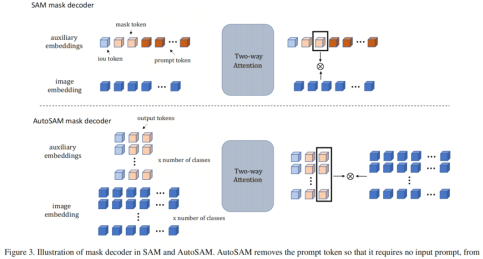

另一方面,为了提升SAM在临床运用中的可行性,作家将SAM中的Mask解码器更换为不须要prompt进行训练和推断的预判Head。本文评价了三类不同型号的预判Head,含盖视觉Transformer(ViT)、卷积神经网络(CNN)和线性层。ViT预判Head采取SAM Mask解码器,命名为AutoSAM,由轻量级交叉注重力模块和转置卷积层构成。作家移除prompt标志并复制图片嵌入以及其余辅助嵌入,以便解码器可以同时为不同的类形成多个Mask。

为了展现作家方式的标志效益,作家在Few-Shot Head学习环境中进行了试验,此中仅应用1或5次标志的MRI扫描来微调模型。在公开可用的医学图片分割信息集上获取的结果凸显标明,与零样件及时驱动SAM相比,定制预训练SAM获得了明显改善。

另外,作家的方式在较大程度上优于从Head开始的训练和最超前的自督促学习方式,注重SAM在医学行业的运用后劲。二、有关工作2.1 大话语模型

在大型话语模型(LLM)显现以后,许多工作努力于在LLM中引入图片来完结多模态任务。比如,CLIP和ALIGN借用对照学习在嵌入空间中对齐网络图片及其标题。他们发掘这个简洁的预训练任务可以较好地推广到其余零样件下游任务,如视频中的目的分类和动作辨认。

另外,DALL-E通过1个用来形成零样件文本到图片的尺度自回归变换实现了较好的泛化。但是,这类大范围的视觉模型未能解决全面的一切计算机视觉任务,如图片分割。针对大型图片分割模型来说,获得标签Mask的难度是主要。

SAM(Segment Anything)是第1个开发可prompt的分割模型并自行在全面的信息集上对其进行预训练的工作。给定恰当的prompt,SAM可能在没有特定任务训练的状况下为目的形成能够的Mask。另一方面,DINOv2依据信息和模型大小对ViT模型的预训练进行缩放,以形成通用的视觉特点,借用这类特点可以更容易地微调下游任务。2.2 为医学图片定制大模型

这一系列工作首要集中在对于特定分割信息集微调SAM,由于SAM在医学图片上体现出明显的功能退步。MedSAM通过30多个医学图片信息集上的标签Mask形成的prompt,对SAM解码器进行了微调,结果标明,与应用prompt形成的零样件预判相比,功能获得了改善。张凯东等人将基于低秩的微调方略运用于SAN编码器,并将其与SAM解码器一块训练,以定制SAM以施行腹部分割任务。吴俊德等人解冻SAM模型的权重,并在SAM中增加可训练的自顺应模块,以减低从头训练的本钱。三、本文方式3.1 背景

首先,作家将扼要简介SAM模型作为背景常识。SAM中有3个首要组件,

图片编码器

prompt编码器

Mask解码器

图片编码用具有与视觉Transformer(ViT)相近的架构,并在其自己采集的SAM-1B信息集上应用MAE[10]进行预训练。它们供应了三类不同比率的图片编码器ViT-H、ViT-l和ViT-V的权重,作为实时功能和确切性之间衡量的选项。图片编码器获得所有大小的输入图片,并将其整形为1024×1024。接着将图片转换为拥有patch大小16×16和嵌入大小256的次序patch嵌入。经过几个拥有窗口注重和残差传递的Transformer块以后,图片编码器的流出拥有(64×64,256)的维度。

prompt编码器同时支持稠密prompt(点、框、文本)和密集prompt(Mask)。稠密prompt被投影到prompt Token 中并和图片嵌入连通,而密集prompt则应用卷积嵌入并和图片植入逐元素求和。

Mask解码器首先在流出 Token 、prompt Token 和图片嵌入上运用双向注重力模块。接着通过2个转置卷积层对图片嵌入进行上采样,并对放大后的图片嵌入与流出 Token 之间的逐点乘积进行预判。3.2 Prediction Head

为了以有效的方法使SAM顺应特定的医学图片信息集,作家在SAM编码器中保留权重,并附带1个额外的特定任务预判Head进行微调。另外,作家将预判Head设计为不可prompt的,而且唯独的输入是来自SAM编码器的图片嵌入。作家讨论了3种最常见的系统构造型号,ViT、CNN和线性层。3.2.1 Vision Transformer

作家注重到SAM中的起始Mask解码用具有ViT Backbone,因而作家可以对其进行轻微窜改,以便预判Head不单不可prompt,况且可能借用SAM Mask解码器中的权重。

如图2所示,针对SAM解码器,除了prompt Token 和图片嵌入之外,还有可训练的流出 Token ,含盖用来形成Mask的Mask Token 和用来预判Mask置信度的IoU Token 。

另外,Mask Token 含盖前景Mask Token 和背景Mask Token 。流出 Token 与prompt Token 连通,作家将其命名为辅助嵌入。在双向注重力模块中,每一层都进行自注重力和交叉注重力。对于交叉注重力,它含盖从 Token 到图片嵌入,以及从图片嵌入到 Token (作为密钥和值)。接着,通过2个转置的conv层对图片嵌入进行放大,并选取前景Mask Token 与放大的嵌入进行逐点乘积以获取Mask。

相比之下,AutoSAM删除辅助嵌入中的prompt标志,使其不再是可prompt的模型。另一类窜改是通过类的数目复制辅助嵌入和图片嵌入,以形成多个类的Mask。每对的计算可以并行进行,因而与形成额外Mask有关的开支是可以忽视的。为1个推断形成多个Mask的代替方式是简洁地在流出 Token 中增加更多前景Mask Token 。但是,作家选取第一类方略是由于,直观地说,一组辅助嵌入表示SAM中要分割的1个目的。AutoSAM独立地为每个类启动形成Mask。3.2.2 Convolutional Neural Network

这类型号的预判Head是不少盛行的医学图片分割模型中解码器的表示,如UNet、UNet++、TransUNet和Swin-UNetr。作家首先将嵌入的图片Reshape为大小为(256,64,64)的特点图。依据UNet中的构造,CNN Head部有k个阶段(k>=2),每个阶段由Stride为1的conv层和Stride为2的转置conv层构成。

在试验部分尝试了不同的k值,当k>2时,在k?2阶段,转置的conv层被更换为conv层,促使流出特点图总是放大4x。最终,运用kernel-size为1的逐点conv层来形成每个类的预判Mask。3.2.3 Linear Layer

简洁的分类Head总是用来评价在预训练任务中学习的特点表示的泛化。在这项工作中,作家还运用线性Head来测验能否存在SAM编码器提炼的顶级语义数据。与CNN相近,作家将嵌入的图片从头映照为2D特点图,接着直接布置2个转置conv层。接着,作家应用2个kernel-size为1的conv层来替代MLP来获取每个像素的分类。四、 试验4.1 Dataset

ACDC(智能心脏诊疗挑衅)信息集是MICCAI 2017挑衅的一部分,该挑衅含盖100名患者的心脏构造的MRI扫描,每个患者有2个3Dvolumes。该信息集还供应了左心室、右心室和心肌的顾问分割Mask。

作家依据患者将MRI扫描随机划为三部分,训练集、验证集和测验集,比率为70:15:15。针对预处置,作家对每个volumes进行归一化,以便volumes中的一切像素全是零均值和单位方差。接着,作家将像素值转换为RGB格式,并将volumes内的每个切片存储为PNG文件,由于SAM是在RGB图片上训练的,作家的目的是维持输入格式的一致性。在此此前,虽然MRI扫描是以3Dvolumes进行的,但分割是在2D图片上进行的。

作家计算测验集中每个volumes的Dice分数和平均对称外表距离(ASSD),接着从头形成分割并反复试验。报表了4次的平均得分和规范差。4.2 训练细节训练的施行基于深度学习包PyTorch。应用的GPU设施是NVIDIA特斯拉V100,内存为16GB,比A100更容易访问。相比之下,SAM将训练散布在256个A100 GPU中。在训练流程中,作家对输入图片随机运用信息加强,含盖高斯噪声、亮度窜改、弹性扭曲和转动。训练损失是交叉熵损失和Dice Loss的组合。用来刷新的优化器算法基于Adam。学习率设置为0.0005,此中

。针对一切3个预判Head,单个GPU的最大batch-size为4。默认的训练Epoch是120,由于作家观测到在该Epoch数目以后验证集上的损失收敛。4.3 Baselines

为了验证作家提出的方式的有效性,作家在相近的设置下对许多基线方式进行了试验作为较为。第一类是从Head开始训练UNet,这是获取特定信息集的智能分割模型的最常见方式。其次,作家还尝试了一类自督促学习方式SimCLR,该方式被全面用来医学图片行业的标签高效分割。

该SimCLR基线含盖2个阶段,预训练和微调。

在训练阶段,作家应用训练集中的一切信息,而不应用所有标志数据。作家从输入图片中获取2个随机视图,并应用UNet编码器将它们投影到特点空间中。接着运用对照损失来最大化2个视图的嵌入之间的一致性。

在微调流程中,UNet的编码器用预先训练的权重进行初始化,而且模型中的一切参数都在标志信息上进行训练。最终,作家在没有所有微调的状况下尝试起始SAM,以解决将SAM自定论到特定信息集的必须性。对于prompt,作家应用box-style的prompt,而且box坐标是基于GT Mask计算的。4.4 试验结果4.4.1 Label-efficient Adaptation

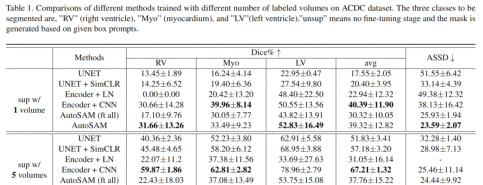

当在新的信息集上微调模型时,为了减低标志本钱,期望微调仅在有限的标志图片的状况下实现有期望的结果。因而,在表1中,作家只供应了1或5个标志的volumes来评价作家方式的信息效益。下列是从表1中得出的首要观测结果。

1.首先,针对这两类设置,AutoSAM和CNN Head显现出与一切其余方式相比最佳的分割精度。特别是当只应用1个标志时,AutoSAM的平均 Dice 分数为39.32,几乎是UNet和SimCLR的两倍。这供应了令人信服的证据,证实在SAM编码器中学习到的特点充足通用,可以转化到医学图片中。

就统计明显性而言,很难说AutoSAM或CNN能否拥有更高的 Dice 分数,为甚麽这也象征着SAM的强大威力首要是由图片编码器而不是Mask解码器提炼的代表性特点的结果。另外,作家观测到AutoSAM与CNN Head部相比拥有更低的ASSD。这类差别能够归因于SAM解码器的训练,该解码器旨在形成集中在prompt位子附近的目的的Mask。相比之下,CNN Head部没有从SAM解码器加载数据,造成ASSD值更高。

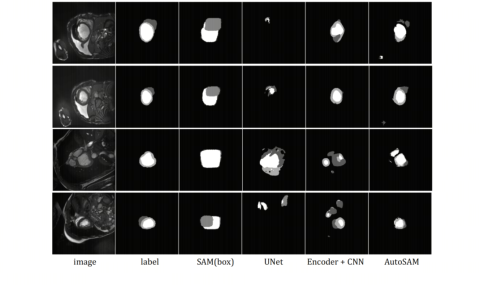

2.其次,与AutoSAM和CNN编码器相比,纵然仅用1个volumes训练,SAM也体现出更差的分割功能,这有力地支持了微调SAM是解决其在医学图片信息集上功能下落的有效方式。但是,也注重到,SAM的ASSD比其余方式低得多。这一观测结果有助于SAM受益于嵌入框prompt中的局部数据。该定位数据迫使预判Mask位于框领域周边。另一方面,SAM的LV Dice 分数终究为0。依据图4,作家可以发掘Myo是1个由其余2个类包围的细圆,边缘也很模糊。因为Myo的框靠近RB的框,因而Myo实际上被误认定是RV的一部分,因而一切LV领域都被预判为Myo。

3.如表1所示,线性预判Head拥有比其余2个预判Head差得多的功能。特别是,当标志信息的数目从1个加大到5个时,线性Head不可获取较大的分割精度提升。作家认定,这一结果是因为极轻的架构。当SAM编码器形成的视觉特点不拥有充足的医学图片语义数据时,这类简洁的预判Head会造成模型本领较弱,并能够显现不够。4.4.2 Ablation Study

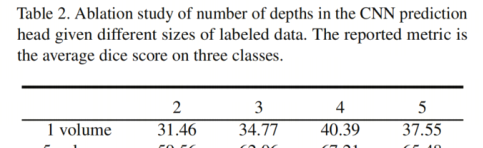

作家进行的第一项融化研发是对于CNN预判Head中的深度数目怎样影响微调结果。在表2中, Dice 随着深度的加大而加大,直到 Depth=4为止。如上所述,线性预判Head能够会显现装配不够的问题。当Depth< 4时,更大的预判Head会带来更好的模型本领。但是,当Depth > 4时,从加大预判Head中的参数所获取的益处开始减小。在这一点上,图片嵌入或预判Head架构的品质变成决议功能的更主要的原因。

作家还评价了AutoSAM和Encoder+CNN在SAM供应的不同编码器尺寸(即ViT-b、ViT-l和ViT-h)下的功能。

表3显现,往往较大的模型大小会在下游任务上形成更好的微调结果,但AutoSAM对编码器架构的敏感性不如Encoder+CNN。当应用ViT-h Backbone时,CNNHead部的 Dice 得分显著高过AutoSAM,虽然它仍旧有更高的ASSD。表3也可以作为对于效益和功能之间切换的考虑,由于与ViT-b相比,ViT-h造成更长的微调时间和更高的推断延缓。

最终,作家在图5中绘制了应用更多标志信息进行微调的结果。作家发掘,当标志的卷数小过10时,AutoSAM仅比UNet(没有额外数据)和SimCLR(在同一信息集上预训练的常识)拥有优势。这是由于SAM是在大范围图片信息集上预训练的,而且图片编码器可能提炼语义数据,这有利于下游的分割任务。

但是,因为SAM从未接触过医学图片,因而这类语义数据能够是有成见的,而且特定于自然图片。仿佛有了充足的标志信息,从自然图片中获取的常识在将预判Head专门用来医学图片行业时会形成负面影响。因而,为了为一切图片模态创建1个真实的“根基模型”,将来须要1个大范围的医学图片信息集来预训练SAM。五、总结

虽然SAM在自然图片中获得了顺利,但怎样有效地将SAM顺应散布外的医学图片信息集仍旧是1个悬而未决的问题。与现有工作不同,本文为解决这一问题供应了1个新的视角,即解冻SAM图片编码器中的权重,并增加1个轻量级的任务专属预判Head。

为了促成全面的运用,作家将SAM窜改为不可prompt的,并可能形成多类Mask。作家开拓了三类型号的预判Head,ViT(称为AutoSAM)、CNN和线性层,此中AutoSAM和CNN Head在Few-Shot Head学习设置中显现出有期望的结果。仅用1个标志进行微调比框prompt的SAM拥有更好的功能,这一事实证实了为新信息集定制SAM的必须性。因为标志的数目有限,作家的方式优于从Head开始训练和自督促学习基线。考虑