斯坦福大学将差分隐私AI模型训练提速10倍,将用于新冠医学影像!

发布日期:2022-03-11 作者:WLT 点击:

作者|图表核心

更快更早地诊断疾病,开发定制药物,研发新药:人工智能在医疗领域潜力巨大,可以显著提高患者的治疗效果,挽救生命,帮助世界各地的人们保持健康,延长生命。

进展迅速,并产生了重大影响。这反过来对用于训练人工智能模型的患者敏感数据的隐私和安全提出了新的挑战。诚然,从公众、医学社区到政府层面对这个问题的讨论越来越多,但我们显然需要研究和改进人工智能技术,以更好地保护数据隐私。

目前,斯坦福大学医学院的研究人员在使用差分隐私这一保护敏感数据的关键方法方面取得了重大突破。通过Graphcore IPU,斯坦福团队可以将具有差分隐私的人工智能的训练速度提高10倍以上,并将这项被认为太难被广泛应用的技术变成现实世界中的实用解决方案。

在使用非隐私敏感的训练数据证明其应用后,斯坦福团队与Graphcore合作,正计划将其技术应用于新型冠状病毒的胸部CT图像,旨在揭示关于这种持续影响全球人民正常生活的病毒的新见解。

人工智能中的数据隐私:挑战

在人工智能中使用敏感的个人数据将带来许多挑战,但两个最重要的挑战是维护数据主权和防止识别个人。这两种情况都有可用的、成熟的技术方案,斯坦福大学的研究让这两种方案更具可行性。

2

力:联邦学习。

使用来自代表世界各地不同人群的许多机构和提供商的数据集的大量和多样化的患者数据进行训练的模型更强大,更不容易出现某些类型的偏见,并且最终更有用。

标准的机器学习方法需要集中数据进行整理。即使我们试图通过删除患者的身份信息来匿名化数据,也需要将这些信息传输给第三方研究机构和组织,这已被证明是一个主要问题。事实上,要求监管将患者数据保留在数据采集管辖范围内的呼声越来越高。

学习可以提供部分答案,因为它允许人工智能模型在匿名患者数据上进行训练,而无需集中这些数据。相反,开发中的模型被发送出去,并根据本地数据进行训练。

虽然联合学习是一项有价值的技术,但最近的研究凸显了一个问题,即通过对来自训练良好的模型的数据进行推理来重新识别匿名健康信息的能力,潜在地将其与个体相关联或恢复原始数据集,将带来隐私漏洞。

由于这个原因,联邦学习的使用也依赖于促进差分隐私的应用。

3差别隐私

通过训练联邦学习模型,差分隐私使得对敏感数据的保护更进一步,没有人可以推断训练数据或从中恢复原始数据集。

差分隐私随机梯度下降(DPSGD)通过剪切和扭曲单个训练数据项的梯度来给匿名患者数据添加噪声。增加的噪声意味着反对者不太可能找到所使用的个体患者数据或恢复用于训练模型的原始数据集。

差分隐私随机梯度下降(DPSGD)明显有利于保护敏感数据,但仍是一个研究缺乏的领域。直到现在还没有应用到大数据集上,因为与传统形式的人工智能计算(如GPU或CPU)配合使用时,计算成本太高。

这是斯坦福大学School 医学计算机视觉专业的放射学研究团队在他们的论文《Nanobatch DPSGD:探索IPU上低批量的ImageNet上的差异私人学习》[1]中重点关注的领域。

由于计算要求,DPSGD通常应用于小数据集并进行分析。然而,斯坦福大学团队能够使用从公开可用的ImageNet数据集获得的130万张图像对IPU系统进行首次分析。在本文中,ImageNet被用作由私有数据组成的大型图像数据集的代理。这项工作可以帮助克服当前大规模部署差分隐私的障碍。

请继续阅读更多关于IPU有效性的信息。

四

使用Graphcore IPU加速NanoBatch)DPSGD

加速处理的常用方法是使用微批量,数据联合处理,联合梯度切割扭曲,而不是基于单个样本的梯度。虽然这样会加快训练速度,但分析表明会降低生成模型的预测质量和生成的隐私保护指数,从根本上违背了其目的。事实上,用微批量1或“纳米批量”进行的实验显示出最高的准确度。

图1:不同梯度累积计数100次训练后的分类精度。我们比较了尺寸为1(“纳米批次”)和尺寸为2的微批次处理。有效批量等于微量批量乘以梯度累积计数。相同的削波和噪声比用于不同的有效批量。因此,具有相同有效批量的项目具有相同的隐私保护保证。

nano-batch DPSGD不常用的一个主要原因是它大大降低了GPU的吞吐量,以至于在ImageNet上运行nano-batch DPSGD ResNet-50需要几天时间。

相比之下,nano-batch DPSGD在IPU上的效率非常高,结果比在GPU上快8到11倍,时间从几天缩短到几个小时。对于IPU来说,由于MIMD架构和IPU的细粒度并行可以实现高得多的处理效率,因此DPSGD所需的额外运算的计算开销要低得多(10%而不是50-90%)。

另外,隐私保护和纳米批量DPSGD需要使用组范数而不是批量范数,IPU可以快速处理,但是会明显拖慢GPU。Graphcore Research最近推出了一种新的规范化技术——代理规范,恢复了组规范的批量规范属性,提高了执行效率。这是一个有趣的未来探索方向。

表1:μbs = 1时不同硬件的吞吐量比较。GPU上的DPSGD使用vmap和TensorFlow差分隐私库。左图:上一代芯片。右图:最新一代芯片。

五

6小时内在ImageNet上训练nano batch DPSGD。

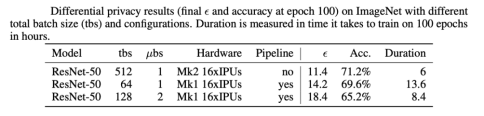

这些技术意味着ResNet-50可以在IPU-POD16系统中在ImageNet上训练100个周期,时间在6小时左右(相比之下GPU需要几天)。准确率达到71%,比非私有基线低5%。由于噪音增加,这是意料之中的。虽然比预期的要好,但仍是未来研究的领域。

对于差分隐私,通常还会报告ε和δ值。该论文表明,对于10-6的δ,ε是11.4,这是一个很好的范围。该团队对如何进一步减少这种情况有一些想法,例如通过更积极的学习率计划来减少培训周期的数量。

表2:使用不同的总批量(TB)和配置在ImageNet上获得的差异隐私结果(第100个周期的最终ε和准确度)。持续时间是通过训练100个周期所需的小时数来衡量的。

这项研究为改善医疗和金融服务以及许多其他行业的应用程序的隐私保护提供了一个重要的机会。在这些行业中,个人敏感数据的保护非常重要。

论文:

https://arxiv.org/abs/2109.12191